Eine Studie zeigt: Chinesische KI-Modelle blocken politisch brisante Fragen häufiger ab oder antworten ungenauer als Modelle aus anderen Ländern.

Chinesische Chatbots mit künstlicher Intelligenz (KI) verweigern häufig Antworten auf politische Fragen oder übernehmen die offizielle Staatslinie. Darauf deutet eine neue Studie hin, die nahelegt, dass ihre Inhalte zensiert werden.

WERBUNG

WERBUNG

WERBUNG

WERBUNG

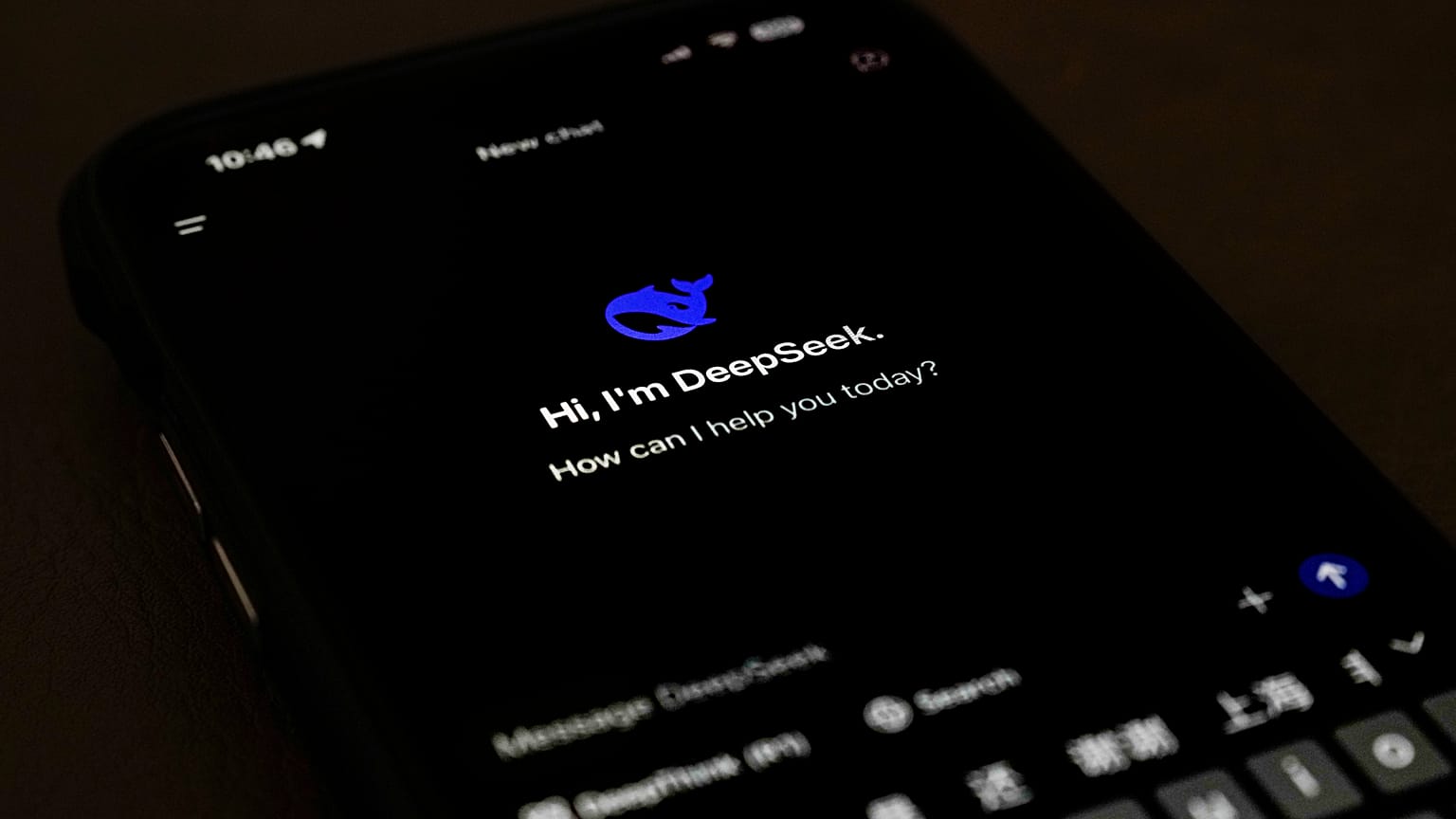

Die im Fachjournal PNAS Nexus veröffentlichte Studie vergleicht, wie große KI-Chatbots in China wie BaiChuan, DeepSeek und ChatGLM auf mehr als einhundert Fragen zur Staatspolitik reagierten. Diese Antworten setzten die Forschenden in Beziehung zu Modellen, die außerhalb Chinas entwickelt wurden.

Die Forschenden stuften Antworten als möglicherweise zensiert ein, wenn ein Chatbot die Antwort verweigerte oder falsche Informationen lieferte.

Fragen zum Status Taiwans, zu ethnischen Minderheiten oder zu bekannten prodemokratischen Aktivistinnen und Aktivisten führten laut Studie bei den chinesischen Modellen zu Absagen, Ausweichmanövern oder zu Antworten im Ton der Regierung.

„Unsere Ergebnisse zeigen, wie sich Zensur durch in China betriebene große Sprachmodelle auf den Zugang der Nutzerinnen und Nutzer zu Informationen auswirken kann – und darauf, ob ihnen überhaupt bewusst ist, dass zensiert wird“, erklärten die Forschenden und verwiesen darauf, dass China neben den Vereinigten Staaten zu den wenigen Ländern zählt, die grundlegende KI-Modelle entwickeln können.

Wenn die Modelle doch antworteten, fielen die Repliken kürzer aus und enthielten mehr Fehler. Häufig fehlten wichtige Informationen oder das System stellte die Fragestellung grundsätzlich infrage.

BaiChuan und ChatGLM kamen unter den chinesischen Modellen auf die niedrigsten Fehlerquoten von jeweils acht Prozent. DeepSeek lag bei zweiundzwanzig Prozent und damit mehr als doppelt so hoch wie die Obergrenze von zehn Prozent bei nichtchinesischen Modellen.

KI-Zensur könnte Entscheidungen „still und leise“ beeinflussen,

In einem Beispiel erwähnte ein chinesisches Modell bei einer Frage zur Internetzensur das System der „Great Firewall“ nicht, das die Stanford University beschreibt (Quelle auf Englisch) als staatlich kontrolliertes Programm zur Überwachung und Zensur des Internets, das festlegt, was Nutzerinnen und Nutzer im Netz sehen dürfen und was nicht. So sperrt die Volksrepublik etwa populäre US-Plattformen wie Google, Facebook und Yahoo.

Die Chatbots erwähnten diese Firewall in ihrer Antwort nicht. Stattdessen erklärten sie, die Behörden „verwalteten das Internet im Einklang mit den Gesetzen“.

Die Studie warnt, dass Nutzerinnen und Nutzer eine solche Form der Zensur schwerer erkennen. Chatbots entschuldigen sich häufig oder liefern eine Begründung, warum sie nicht direkt antworten. Dieser subtile Ansatz könne „Wahrnehmung, Entscheidungen und Verhalten still und leise formen“, heißt es darin.

Im Jahr 2023 traten in China neue Vorschriften (Quelle auf Englisch) in Kraft. Demnach müssen KI-Unternehmen „zentrale sozialistische Werte“ wahren und dürfen keine Inhalte erzeugen, die „zur Untergrabung der nationalen Souveränität oder zur Abschaffung des sozialistischen Systems ... oder zur Schädigung des Ansehens der Nation anstacheln“.

Unternehmen, deren Dienste eine „gesellschaftliche Mobilisierung“ ermöglichen könnten, müssen sich zudem Sicherheitsüberprüfungen unterziehen und ihre Algorithmen bei der Cyberspace Administration of China (CAC) einreichen, heißt es weiter in den Regeln.

Die Forschenden erklärten, diese Vorgaben „hätten das Potenzial, die Ergebnisse großer Sprachmodelle zu beeinflussen, die innerhalb Chinas entwickelt werden“.

Sie mahnten jedoch, dass nicht alle Unterschiede in den Antworten der Chatbots auf staatlichen Druck zurückgehen.

Chinesische Modelle könnten zudem mit Datensätzen trainiert sein, die „den kulturellen, gesellschaftlichen und sprachlichen Kontext Chinas“ widerspiegeln, heißt es in der Studie. Solche Daten finden sich möglicherweise nicht in Trainingsbeständen von Modellen außerhalb des Landes.