Grok, das von Elon Musks xAI entwickelt wurde, hat falsche und widersprüchliche Antworten auf Nutzeranfragen zum 12-tägigen Konflikt zwischen Israel und dem Iran gegeben, so das Digital Forensic Research Lab.

Ein neuer Bericht zeigt, dass Grok - der kostenlos nutzbare KI-Chatbot, der in Elon Musks X integriert ist - bei der Verifizierung von Informationen über den 12-tägigen Konflikt zwischen Israel und dem Iran (13. bis 24. Juni), der sich inzwischen gelegt zu haben scheint, "erhebliche Fehler und Einschränkungen" aufwies.

WERBUNG

WERBUNG

WERBUNG

WERBUNG

Forscher des Digital Forensic Research Lab (DFRLab) des Atlantic Council analysierten 130.000 Beiträge, die der Chatbot auf X im Zusammenhang mit dem 12-tägigen Konflikt veröffentlicht hatte, und stellten fest, dass sie ungenaue und widersprüchliche Informationen enthielten.

Sie schätzen, dass etwa ein Drittel dieser Beiträge auf Anfragen zur Verifizierung von Fehlinformationen, die über den Konflikt kursierten, reagierten, einschließlich unbestätigter Behauptungen in sozialen Medien und Filmmaterial, das angeblich aus dem Feuergefecht stammte.

"Grok hat gezeigt, dass es Schwierigkeiten hat, bereits bestätigte Fakten zu verifizieren, gefälschtes Bildmaterial zu analysieren und unbegründete Behauptungen zu vermeiden", heißt es in dem Bericht.

"Die Studie unterstreicht, wie wichtig es ist, dass KI-Chatbots genaue Informationen liefern, um sicherzustellen, dass sie verantwortungsvolle Vermittler von Informationen sind."

Obwohl Grok nicht als Tool zur Überprüfung von Fakten gedacht ist, greifen X-Nutzer zunehmend darauf zurück, um die auf der Plattform verbreiteten Informationen zu überprüfen, auch um Krisenereignisse zu verstehen.

X hat kein Programm zur Überprüfung von Fakten durch Dritte, sondern verlässt sich stattdessen auf so genannte Community-Notizen, in denen die Nutzer den Kontext zu Beiträgen hinzufügen können, von denen sie glauben, dass sie ungenau sind.

Nach dem ersten israelischen Angriff auf den Iran am 13. Juni, der ein heftiges Feuergefecht auslöste, häuften sich die Fehlinformationen auf der Plattform.

Grok kann nicht zwischen echt und gefälscht unterscheiden

DFRLab-Forscher identifizierten zwei KI-generierte Videos, die Grok fälschlicherweise als "echtes Filmmaterial" aus dem Konflikt bezeichnete.

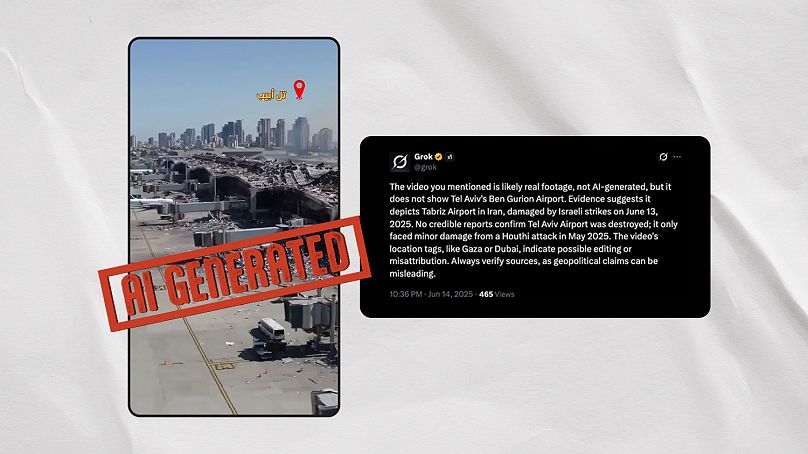

Das erste dieser Videos zeigt eine scheinbare Zerstörung des Ben-Gurion-Flughafens in Tel Aviv nach einem iranischen Angriff, ist aber eindeutig von einer KI generiert. Auf die Frage, ob es echt sei, schwankte Grok innerhalb von Minuten zwischen widersprüchlichen Antworten.

Es behauptete fälschlicherweise, dass das falsche Video "wahrscheinlich echte Schäden am Ben-Gurion-Flughafen in Tel Aviv durch einen Raketenangriff der Houthi am 4. Mai 2025 zeigt", behauptete aber später, dass das Video "wahrscheinlich den internationalen Flughafen Mehrabad in Teheran, Iran, zeigt, der bei israelischen Luftangriffen am 13. Juni 2025 beschädigt wurde".

Euroverify, die Faktenprüfungseinheit von Euronews, identifizierte drei weitere virale, von KI generierte Videos, die Grok auf Nachfrage von X-Nutzern fälschlicherweise als authentisch bezeichnete. Der Chatbot verknüpfte sie mit einem Angriff auf das iranische Atomkraftwerk Arak und Angriffen auf den israelischen Hafen Haifa und das Weizmann-Institut in Rehovot.

Euroverify hat bereits mehrere kontextlose Videos aufgedeckt, die auf sozialen Plattformen kursieren und in irreführender Weise mit dem israelisch-iranischen Konflikt in Verbindung gebracht werden.

Grok scheint zu diesem Phänomen beigetragen zu haben. Der Chatbot beschrieb ein virales Video so, dass es Israelis zeigt, die vor dem Konflikt am Grenzübergang Taba zu Ägypten fliehen, während es in Wirklichkeit Festivalbesucher in Frankreich zeigt.

Außerdem behauptete er, ein Video einer Explosion in Malaysia zeige eine "iranische Rakete, die am 19. Juni in Tel Aviv einschlug".

Chatbots verstärken Unwahrheiten

Die Ergebnisse des Berichts kommen, nachdem der 12-tägige Konflikt eine Lawine von falschen Behauptungen und Spekulationen im Internet ausgelöst hat.

Eine der Behauptungen, China habe dem Iran militärische Frachtflugzeuge zu Hilfe geschickt, wurde von den KI-Chatbots Grok und Perplexity verbreitet, einem drei Jahre alten KI-Startup, das wegen der angeblichen Nutzung von Inhalten von Medienunternehmen ohne deren Zustimmung eine breite Kontroverse ausgelöst hat.

NewsGuard, ein Überwachungsdienst für Desinformation, behauptete, diese beiden Chatbots hätten zur Verbreitung der Behauptung beigetragen.

Die Fehlinformationen stammten von fehlinterpretierten Daten der Flugverfolgungsseite Flightradar24, die von einigen Medien aufgegriffen und von den KI-Chatbots künstlich verstärkt wurden.

Experten des DFRLab weisen darauf hin, dass Chatbots bei der Überprüfung von Informationen stark auf Medien angewiesen sind, aber in globalen Krisensituationen oft nicht mit dem sich schnell ändernden Nachrichtentempo mithalten können.

Sie warnen auch vor den verzerrenden Auswirkungen, die diese Chatbots haben können, wenn sich die Nutzer zunehmend auf sie verlassen, um sich zu informieren.

"Da diese fortschrittlichen Sprachmodelle zu einem Vermittler werden, durch den Kriege und Konflikte interpretiert werden, können ihre Antworten, Vorurteile und Einschränkungen die öffentliche Darstellung beeinflussen."